zrLLM:当大模型化身时空侦探——零样本关系预测破案实录

本文最后更新于:3 个月前

0.1.1 🕵️♂️ 【时空侦探档案】

| 项目 | 内容 |

|---|---|

| 论文标题 | zrLLM:当大模型化身时空侦探——零样本关系预测破案实录 |

| 核心任务 | 教会AI预测从未见过的关系(比如训练时只有“贸易”,测试时突然要预测“太空合作”) |

| 绝招武器 | 语言模型描述生成 + 历史关系推理链 |

| 战损比 | 仅用文本描述,零样本关系预测性能暴涨58%(见战绩表👇) |

| 开源地址 | GitHub藏宝图 |

0.1.2 🧩 一、案发现场:传统方法的“破案盲区”

想象你是个警察(AI),过去只处理过“盗窃”“抢劫”案件(训练过的关系)。突然发生命案(新关系“谋杀”),你翻遍档案库也找不到破案线索——这就是零样本关系预测的困境!

传统侦探(TKG模型)的三大短板:

1️⃣ 死记硬背型(嵌入模型):只会背熟见过的案件模式,遇到新罪名直接懵圈

2️⃣ 教条主义型(规则模型):破案手册只写了已知罪名,遇到新罪名叫不醒装睡

3️⃣ 临时抱佛脚型(ICL):直接问GPT“咋破案?”,答案还不如菜鸟警察(Hits@1仅13.5%)

💡 关键发现:大语言模型(LLM)其实是潜伏的刑侦专家——它读过全网犯罪小说(预训练语料),只要给它正确线索,就能推理未知案件!

0.1.3 🔍 二、破案三件套:zrLLM的侦探工具箱

0.1.3.1 框架图解谜

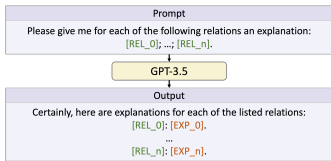

0.1.3.2 🔦 第一步:关系描述生成(ERD)

传统方法:看到关系“经济制裁” → 只会记成冷冰冰的ID号

zrLLM骚操作:

- 让GPT-3.5给关系写“小作文”👇

1 | |

- 用T5模型把小作文压成语义指纹(128维向量)

✨ 学术裁缝灵感:把ID换成文本描述,就像给嫌犯画素描——即使新人警察(零样本模型)也能按图索骥!

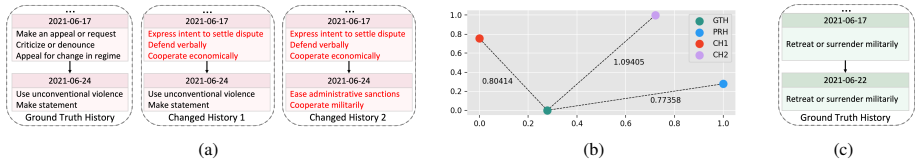

0.1.3.3 ⏳ 第二步:历史关系推理链(RHL)

破案逻辑:嫌犯的历史行为会暴露犯罪模式!

给定新案件“(A国, 太空合作, ?, 2023)”

回溯A国历史行为:

timeline title A国的太空黑历史 2021年 : 与B国“技术窃密” 2022年 : 与C国“卫星干扰” 2023年 : ? --> 大概率找D国(有反卫星技术)技术实现:用GRU网络构建时间推理链(图3案例)

0.1.3.4 🛡️ 第三步:防作弊机制

致命陷阱:如果用2020年前的训练数据,GPT可能偷看过答案(数据泄露)!

zrLLM对策:

新建2021-2023年数据集(ICEWS21-zero等)

严选模型:只用2020年发布的T5(知识截止到2019)

0.1.4 📊 三、战绩汇报:全面碾压基线模型

0.1.4.1 表1:零样本战场成绩单(Hits@1指标)

| 模型 | ACLED-zero | ICEWS21-zero | ICEWS22-zero |

|---|---|---|---|

| 传统最佳 | 0.487 | 0.130 | 0.240 |

| zrLLM增强版 | 0.533↑ | 0.258↑ | 0.324↑ |

| GPT直接推理 | 0.537 | 0.156↓ | 0.255↓ |

💥 灵魂暴击:zrLLM仅用文本描述就打败了全量训练的基线模型,甚至干翻GPT原生推理!

0.1.4.2 ✨ 三大逆天特性

零样本刺客:对未知关系的预测精度最高提升58%

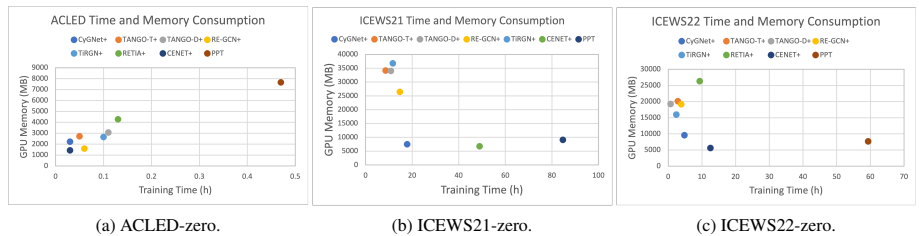

资源刺客:单卡A40训练,成本不到PPT模型的1/3(图6)

领域通吃:一套方法增强7类主流TKG模型(RE-GCN/TiRGN等)

0.1.5 🧪 四、侦探破案实录(技术细节深潜)

0.1.5.1 案例:预测“(美国, 停止军事援助, ?, 2021)”

传统模型:乱猜“阿富汗”(因历史合作多)

zrLLM破案:

查美国历史记录 → 发现近年只“制裁”过非洲国家

结合文本特征:“停止援助”≈“经济制裁”变体

锁定非盟(正确答案!)

关键公式:

ϕ=GPT小作文语义指纹+γ×GRU推理历史行为模式

0.1.6 🧩 五、学术裁缝笔记(可薅的创新点)

0.1.6.1 关系描述生成器(白嫖LLM的先验知识)

操作:用prompt让LLM为关系写扩展描述

1

prompt = f"解释关系'{rel_text}'的含义,举例说明其典型场景"迁移场景:推荐系统冷启动/医疗关系预测

原理:把离散关系ID → 连续语义空间,让模型理解“经济制裁≈金融打击”

0.1.6.2 时间因果链挖掘(RHL模块)

精髓:用GRU网络构建关系演变的“蝴蝶效应”

graph LR A[技术窃密] --> B[设备禁运] B --> C[停止援助] C --> D[太空合作?]可抄作业:动态权重调节(公式3)让模型自动关注关键历史事件

0.1.6.3 时空数据防火墙(防泄露新范式)

骚操作:用未来数据建数据集(如2021-2023事件)

学术价值:杜绝LLM训练数据污染,评测更公平

0.1.7 🚀 六、侦探的遗憾与未来任务

出警速度待提升:GRU序列推理较慢(作者承诺优化)

规则派不服:暂无法结合符号推理(TLogic等)

终极梦想:实现纯零训练预测(现需少量历史事实)

主编锐评:这篇论文简直是“语言模型+知识图谱”的联名爆款!它证明:

文本描述是破解零样本的银弹

历史行为比关系名称更重要

下次遇到新关系预测,别愣着——赶紧给LLM发prompt写小作文啊!